隨著技術的不斷進步

AI應用場景越來越豐富

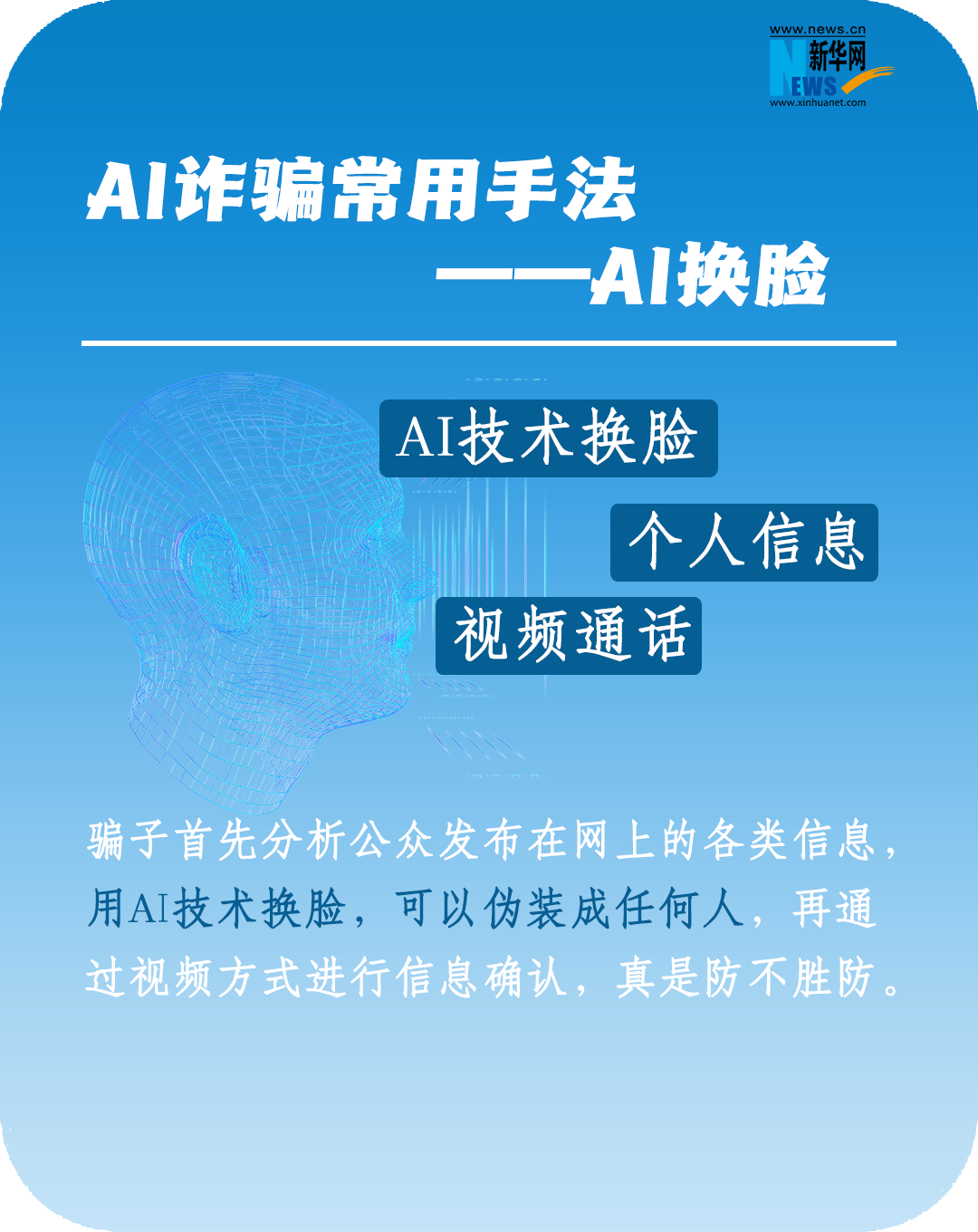

“一鍵換臉”,和喜愛的偶像合影

大叔通過AI技術秒變蘿莉禦姐

“AI孫燕姿”剛“出道”就爆火

……

曾經離我們很遙遠的AI

如今正迅速進入大眾生活

需要注意的是

騙子也盯上了AI技術

利用它玩起了“真假美猴王”

和你視頻對話的可能不是本人

近日

包頭警方發布一起利用AI實施電信詐騙的典型案例

“好友”突然打來視頻

福州的郭先生在確認過長相和聲音後仍被騙

10分鐘內被騙走430萬元

原來是騙子通過智能AI換臉和擬聲技術

佯裝好友對他實施了詐騙

幸運的是

接到報警後,福州、包頭兩地警銀迅速啟動止付機制

成功止付攔截336.84萬元

案件披露後

#AI詐騙正在全國爆發#的話題衝上熱搜

引發網友廣泛關注

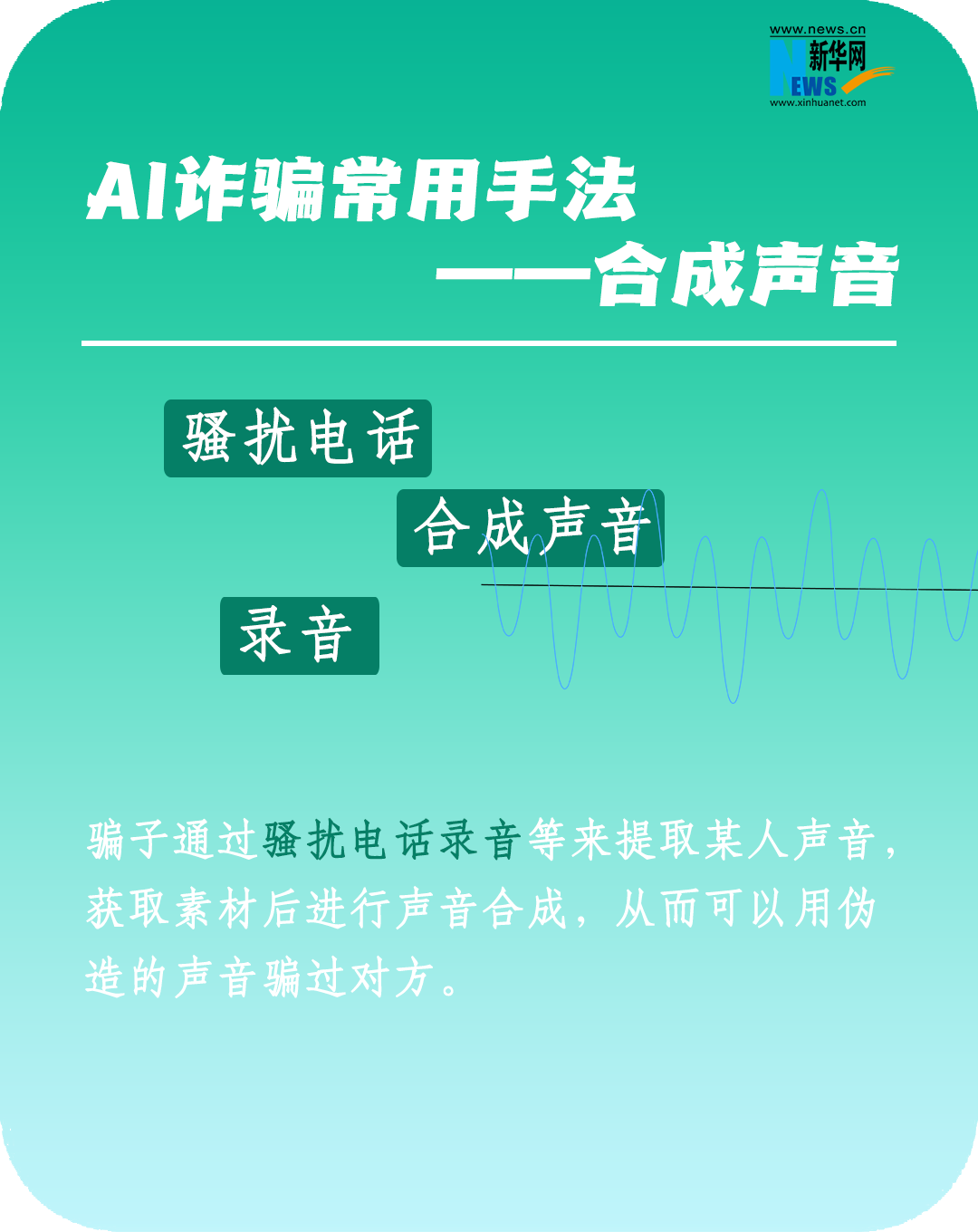

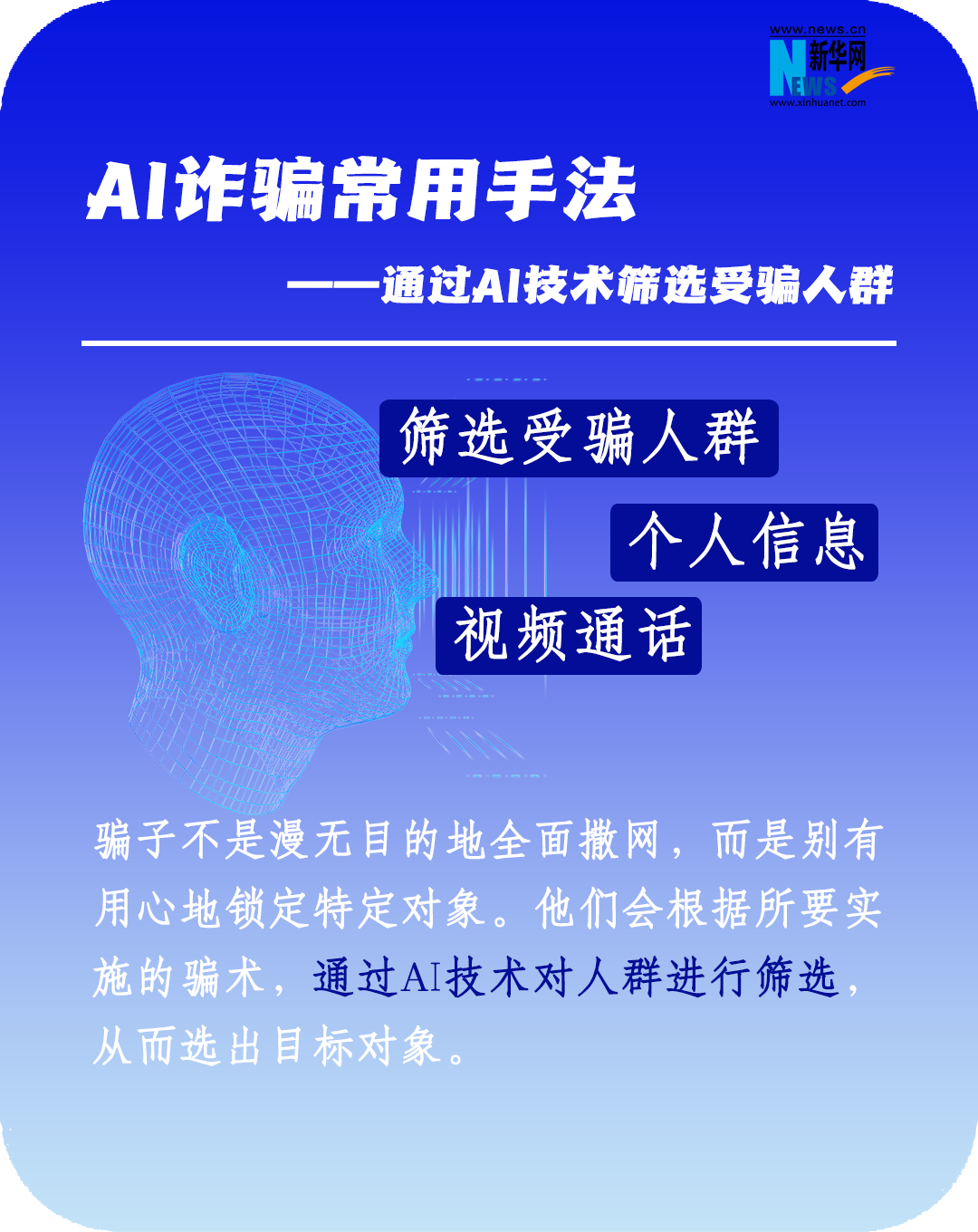

AI詐騙常用手法

如何防范AI詐騙

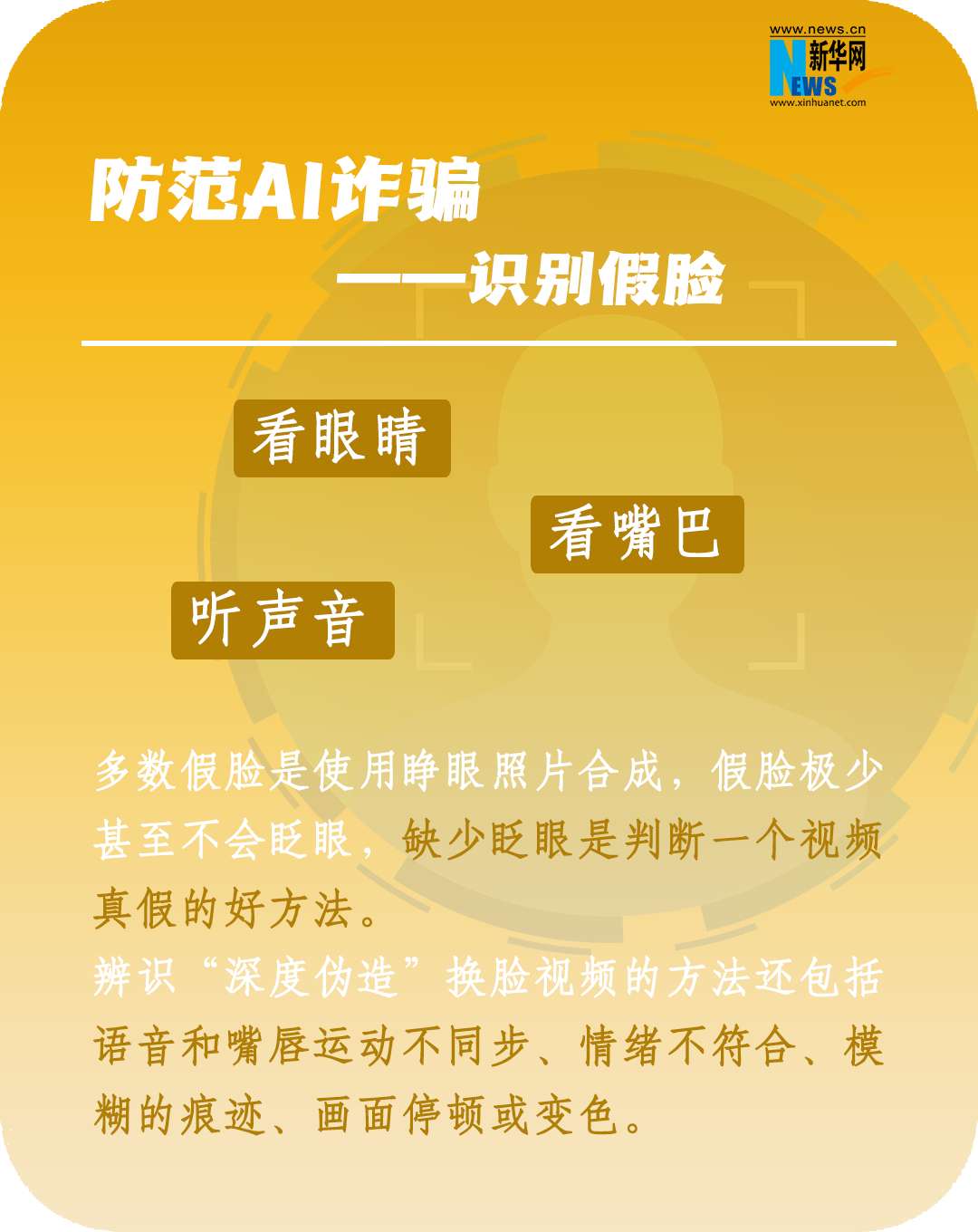

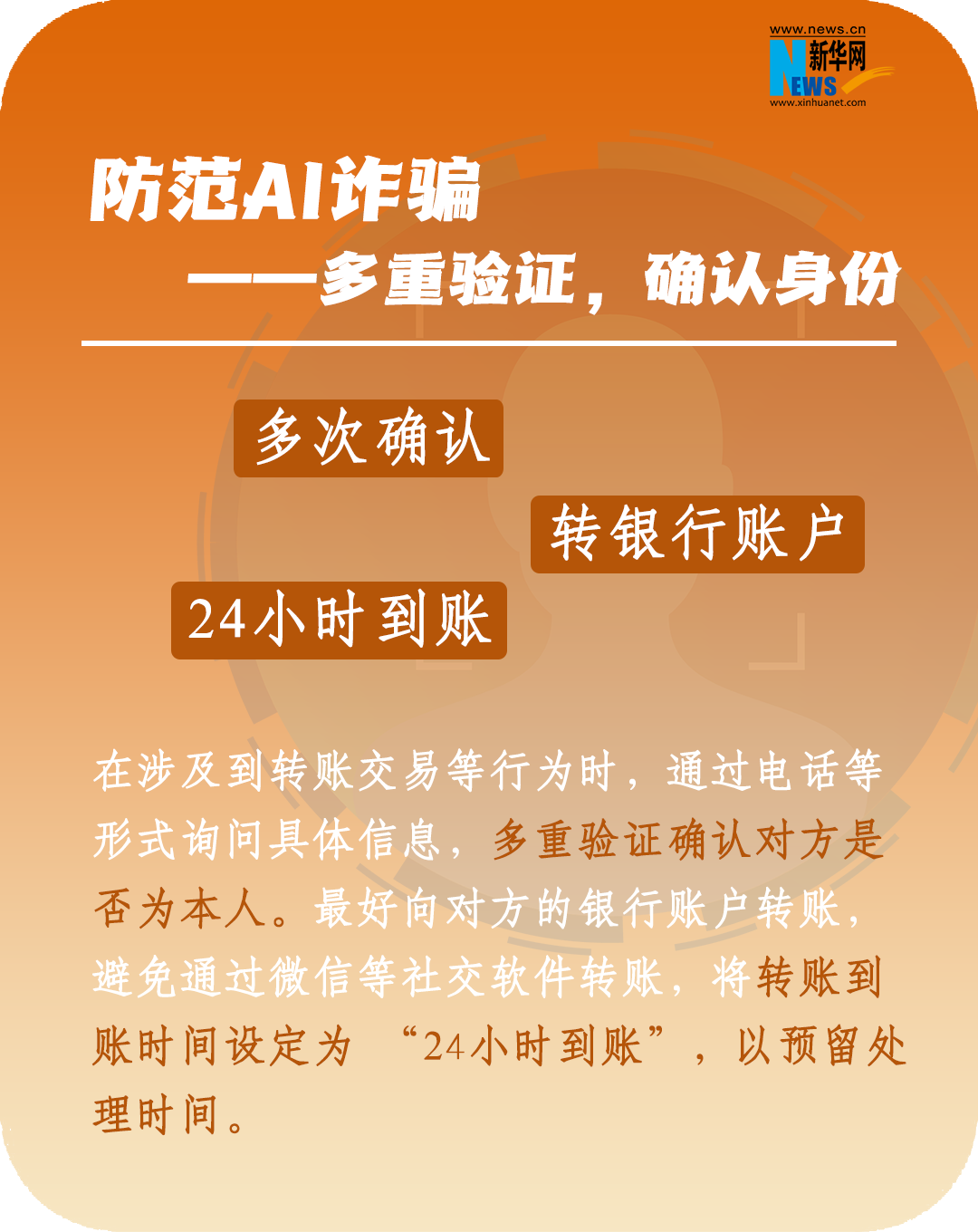

那麼面對AI換臉詐騙就沒轍了嗎?

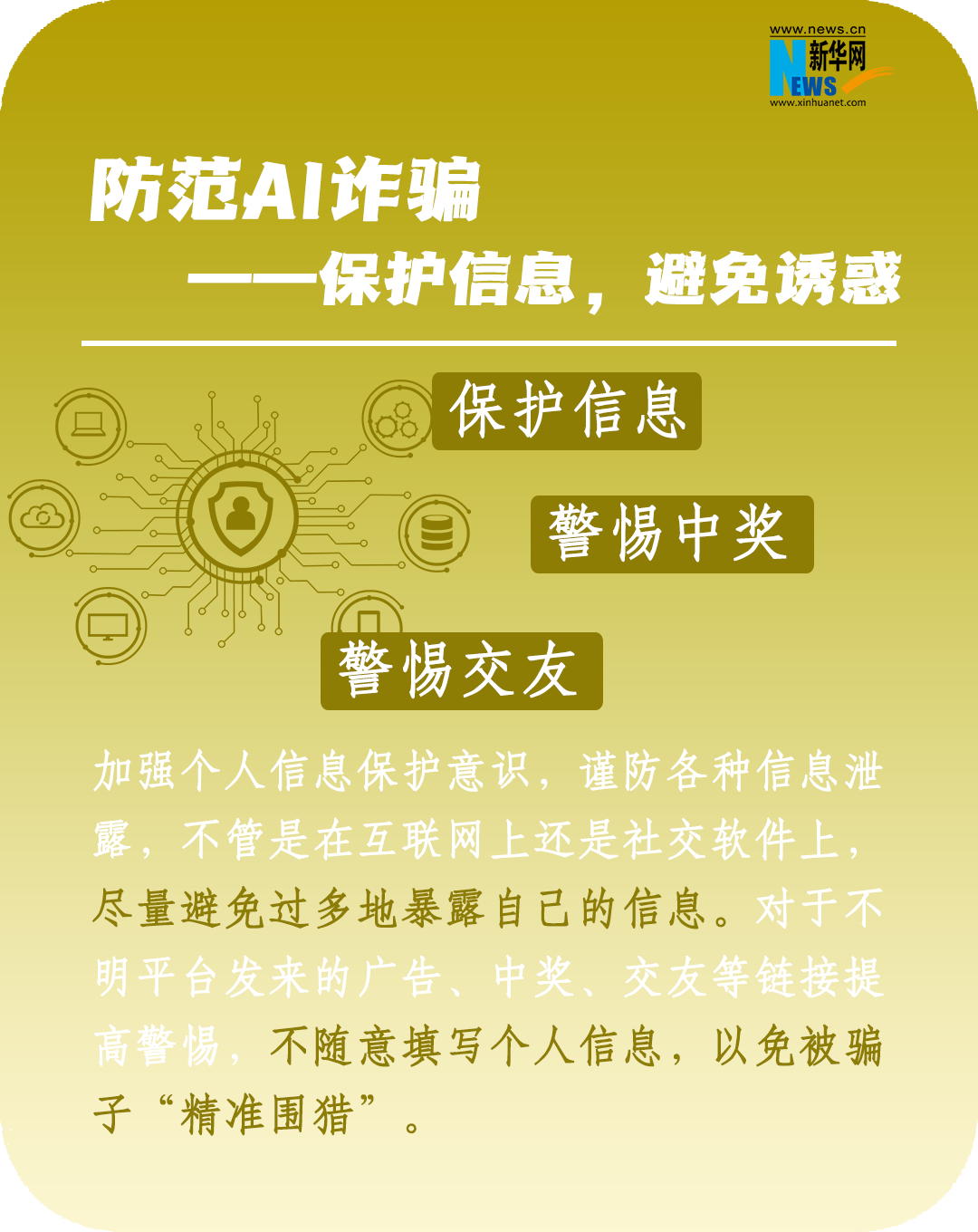

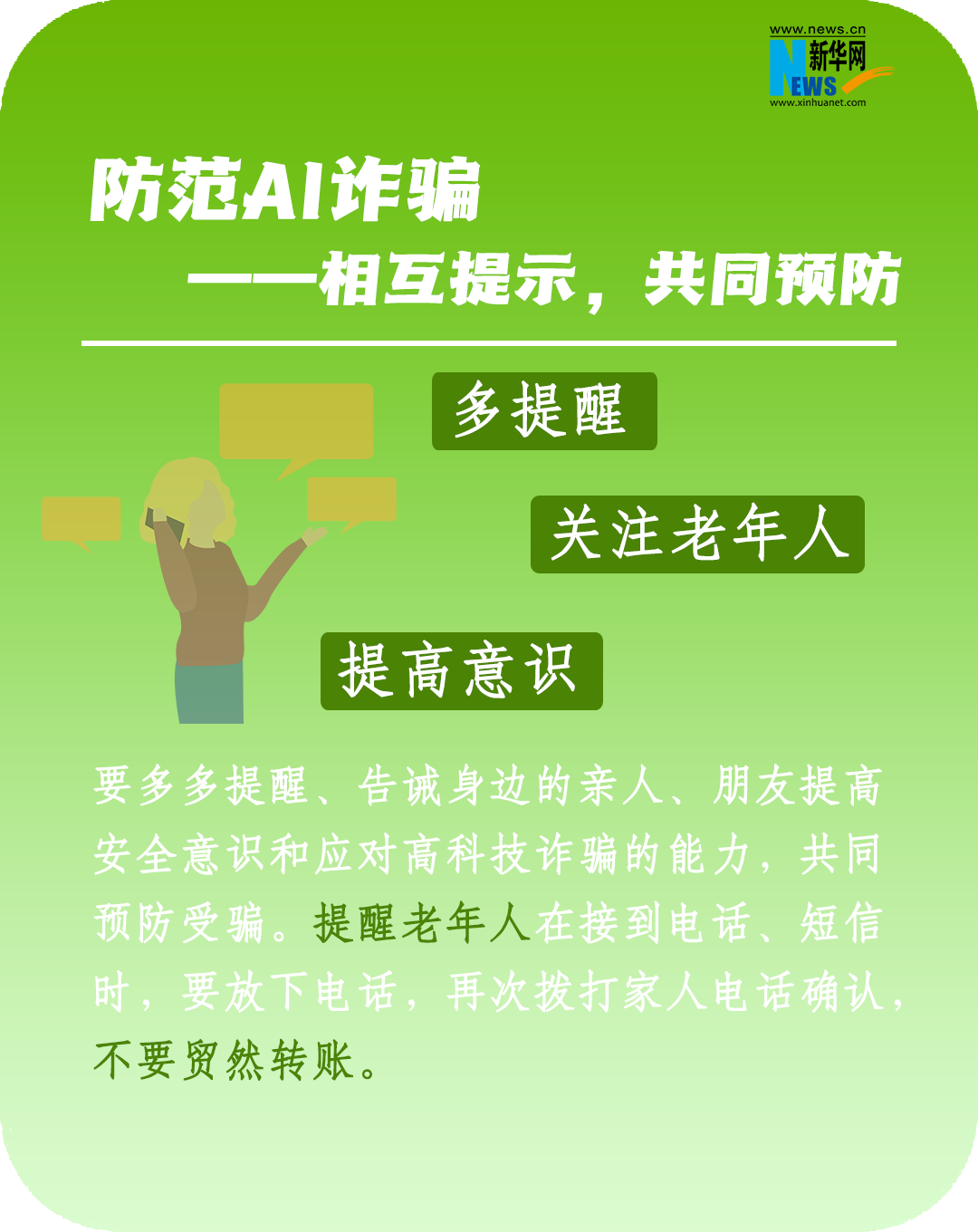

在AI時代,眼見、耳聽都不一定為實了,大大增強了迷惑性。運用AI技術,再加上套路和劇本的演繹,這樣的詐騙手段,小夥伴們要hold住。

詐騙“魔高一尺”,防范“道高一丈”。

監管先行避免AI“野蠻生長”

需要厘清的是,AI換臉雖然是新事物,但卻不存在“監管空白”或“無法可依”的情況。

針對技術手段日益更新的AI詐騙事件,2022年11月25日,國家互聯網資訊辦公室、工業和信息化部、公安部聯合發布《互聯網資訊服務深度合成管理規定》(以下簡稱規定),自2023年1月10日起施行。規定要求深度合成服務提供者對使用其服務生成或編輯的資訊內容,應當添加不影響使用的標識。提供智能對話、合成人聲、人臉生成、沉浸式擬真場景等生成或者顯著改變資訊內容功能的服務的,應當進行顯著標識,避免公眾混淆或者誤認。要求任何組織和個人不得採用技術手段刪除、篡改、隱匿相關標識。

今年4月11日,國家網信辦起草了《生成式人工智慧服務管理辦法》(徵求意見稿),提出AI內容必須真實準確,其中也明確提到,禁止非法獲取、披露、利用個人資訊和隱私、商業秘密。

【溫馨提示】

使用AI“換臉”及類似軟件風險極高,伴隨著法律風險和侵權糾紛。“AI換臉技術”即便只是用來搞笑或者制作惡搞照片,也有可能涉及侵犯肖像權、名譽權,造成嚴重後果的,還可能構成侮辱罪或者誹謗罪。希望大家依法使用該項技術,一旦遇到類似本案中利用“AI換臉技術”實施犯罪行為的,應第一時間固定證據,並及時向司法機關報案。

策劃:程立葳

文字:連雨欣

制圖:袁羽(漫畫除外)

參考資料:公安部網安局微信號、新華社、人民日報、光明日報、東南網等